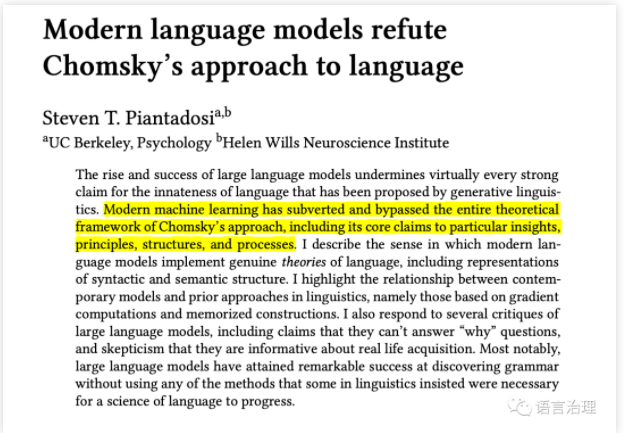

近期乔老爷子在纽约时报观点栏目再次谈了自己对ChatGPT的看法,然后就是一石激起千层浪,各方专家都表达了自己的不同意见,这包括普林斯顿大学Goldberg教授,然后UC Berkeley 的Steven T. Piantadosi 博士写了一篇专门批驳的文章,文章信息量很大,很精彩,甚至可以说有点烧脑,作者的批判主要集中在以下方面:1. 现代语言模型的崛起和成功削弱了生成语法学提出的关于语言天赋性的强烈主张。2. 现代机器学习已经颠覆并绕过了乔姆斯基方法的整个理论框架,包括其对特定洞见、原则、结构和过程的核心主张。3. 现代语言模型实现了真正的语言理论,包括句法和语义结构的表征。4. 生成语法方法在任何领域都不具有竞争力,并且可以说已经避免了对其核心假设进行实证测试。

那么这个文章具体是怎么展开的呢?下面小编分享一下文章中的精彩片段:

Modern language models refute Chomsky’s approach to language

诺姆-乔姆斯基在语言学领域享有几十年的特权和显赫地位后,他的语言科学研究路径或许开始过时了。这个故事在某种程度上是一个关于当一个学术领域将自己与本应是互补的努力隔离开来时会发生什么的警示故事。乔姆斯基的方法和手段经常被认为是有问题的,但人们还没有广泛认识到其基本思想是如何被最近的计算科学进展所破坏的。几乎所有计算语言任务的技术水平都利用了深度神经网络(LeCun etal.,2015),通常是被称为转化器的神经网络(Vaswani etal.,2017;Brown etal.,2020;Bommasani etal.,2021)。这些是文本的模型,在基于互联网的巨大数据集上进行训练,以预测即将到来的语言材料(通常是在子词但超字符的编码)。有几项进展使这些模型获得了巨大的成功。首先,我们已经能够在大规模的数据集上训练它们。这部分是由于计算的进步(例如计算任意模型的导数),部分是由于从互联网上获得了大量的文本集。一个典型的语言模型可能要在数千亿的标记上进行训练,估计仅能源就需要花费数百万美元。其次,该模型的架构可以灵活地处理非本地的依赖关系,并允许对一个词的预测有可能依赖于远处的材料。关键的结果是,领先的模型不仅能够生成语法句子,而且能够生成整个话语、脚本、解释、诗歌等。近年来,这一追求被人工智能公司所引领(Ahmed etal.,2023)。这些工具不仅令人印象深刻,而且在哲学上也很重要。它们之所以重要,是因为它们成功地遵循了一种非常特殊的方法:它们只对文本预测进行训练。这意味着这些模型对文本中的下一个词形成了概率性的预期,并且它们使用真实的下一个词作为错误信号来更新它们的潜在参数。这个想法至少可以追溯到1990年的Elman,他展示了在文本预测上训练一个神经网络如何能够导致它发现潜在语言系统的关键部分。现代模型是埃尔曼想法的一个显著的科学胜利。但是,虽然现代模型继承了他的一般设置,但进步却增加了一些关键的差异。最重要的可能是,现代模型包括一个注意力机制,允许从过去的某个时间段预测下一个词的顺序。例如,在上面的蚂蚁故事中,当它说 "其他蚂蚁对亚历克斯的......感到震惊和惊奇 "时,它从之前的几十个词中检索出 "亚历克斯 "这个名字。这可能是大型语言模型区别于早期最流行的模型的关键属性。例如,一个n-gram模型会估计并使用一个只取决于前面几个词的条件概率(例如𝑛=2、3、4、5);无语境语法做出独立假设,使词条不影响那些远处的词。大型语言模型不仅允许这种长距离的影响,而且允许它们采取相对不受约束的形式,因此能够诱导出一些函数,这些函数显然在语境中的单词预测方面做得非常出色。这些模型的第二个关键特征是,它们整合了语义和语法。这些模型中的词的内部表示被储存在一个矢量空间中,这些词的位置不仅包括意义的某些方面,还包括决定词如何按顺序出现的属性(如语法)。对于语境和词义如何预测即将到来的材料,有一个相当统一的界面--语法和语义在模型中没有被分离成区分的组成部分,也没有被分离成独立的预测机制。正因为如此,这些模型找到的网络参数将句法和语义属性融合在一起,两者以非微妙的方式相互作用,并与注意力机制相互作用。这并不意味着模型不能区分句法和语义,或者例如不考虑语义而反映句法结构(见下面的例子),但它确实意味着这两者可以相互启发。模型的一个相关方面是,它们具有数十亿到数万亿参数的巨大记忆容量。这使它们能够记忆语言的特异性,这样它们就继承了语言学家强调结构的重要性的传统(Goldberg 1995, Jackendoff 2013, Goldberg 2006, 2003, Tomasello 2000, McCauley & Christiansen 2019, Tomasello 2005, Edelman & Waterfall 2007)(关于大型语言模型的结构语法分析,见Weissweiler等人2023)。对于像这样的大规模过度参数化的模型是如何工作的,我们应该有一个很好的心理暗示,即它们有丰富的潜在空间来推断隐藏的变量和关系。隐性(或潜在)变量一直是计算理论和非正式理论都试图捕捉的语言的关键方面之一(Pereira 2000, Linzen & Baroni 2021)。在一个句子的中间,有一个关于句子的潜在结构的隐性变量;在说一个模棱两可的词时,我们心中有一个关于我们打算表达什么意思的隐性变量;在整个话语中,我们心中有一个更大的故事弧线,它只在多个句子中展开。语言学的形式主义也试图描述这些隐藏的变量。但大型语言模型所做的是推断可能的隐藏结构,因为这种结构允许他们更好地预测即将到来的材料。这使得它们在概念上类似于数学中的嵌入定理(Packard etal.,1980;Takens,1981;Ye & Sugihara,2016),这些定理表明,有时一个动态系统的完整几何结构可以从其状态的低维投影中恢复到时间上的演变。语料库是句法和思维的低维投影,因此,智能学习系统至少可以从观看文本中恢复这些认知系统的某些方面,这并不是不可信的(Piantadosi & Hill 2022)。在详细的分析中可以看到大型语言模型中存在的结构,随着模型在训练后生成文本,其内部状态代表了句法结构和语义的潜在方面(Manning et al. 2020, Futrell et al. 2019, Linzen & Baroni 2021, Pavlick 2022)。训练后的模型内部表征状态和注意模式的结构来捕捉树状结构,与人类注释的解析树有很强的相似性(Manning等人,2020),一个模型的树状结构的程度甚至可以预测它的泛化性能(Murty等人,2022)。这些模型似乎在涉及追踪正确的潜在状态的结构上表现良好,比如功能词(Kim等人,2019年)和填空式依赖(Wilcox等人,2018年)。事实上,一些模型的内部处理结构似乎自发地形成了一个代表语篇的直观管道,然后是解析、语义分析等(Tenney, Das, et al. 2019, Liu et al. 2019)。所有这些都是可能的,因为大型语言模型发展了对关键结构和依赖关系的表征,只是这些表征是以语言学不熟悉的方式进行参数化。有趣的一点是,现代语言模型是如何整合不同的语言计算方法的,不是通过直接编码,而是通过允许它们从内置的架构原则中出现(曼宁等人 2020)(埃尔曼等人 1996)。例如,这些模型似乎有层次结构(Manning et al. 2020)和递归的表征,在这个意义上,它们知道例如嵌入句子和相对句。它们几乎肯定也有约束的类似物,在谐音(Smolensky & Legendre 2006, Prince & Smolensky 1997)和模型理论语法(Pullum 2007, 2013)等方法中很流行。这些模型可能包括硬约束(如词序)和可违反的、概率性的约束(Rumelhart & McClelland 1986)。他们肯定会记住一些结构(Goldberg 1995, Jackendoff 2013, Goldberg 2006, 2003, Tomasello 2000, Edelman & Waterfall 2007)。所有这些都会在参数中实现,以达到很好地预测文本的总体目标。

语言科学领域的许多人认为这种模型至少在某种程度上与未来有关(Bommasan etal.2021,Baroni 2022,Pater 2019)。毕竟,它们是现有的唯一能很好地捕捉人类语言基本动态的模型。然而,由于是神经网络,它们--至少是初始状态--完全不同于主导语言生成方法的规则和原则。如上所述,它们的参数来体现语言的理论,包括通过一个句子和一个话语来表示潜在的状态。在其他科学中,如飓风或大流行病的建模,也有完全相同的调整参数以正式化然后比较理论的逻辑:任何一组假设都会产生预测的分布,而假设的调整是为了做出可能的最佳预测。通过这种方式,学习机制在理论空间中配置模型本身,以满足期望的目标函数。对于飓风或大流行病,这是科学所能达到的严格程度;对于单词序列,每个人似乎都失去了理智。例如,在与Gary Marcus讨论GPT-3时, Chomsky最积极的说法是,它有 "模仿数据中的一些规律性的能力",然后很快说:"事实上,它唯一的成就是用掉了加州的大量能源 "。在另一次采访中,他总结说,在我们对语言的理解方面,这些模型 "取得了零的成就"。乔姆斯基等人2023年将这些模型描述为 "在一些狭窄的领域 "是有用的,但受到 "不可消除的缺陷 "的阻碍,使它们 "与人类推理和使用语言的方式有深刻的区别"。正如网上迅速指出的那样,他们提出的几个例子--如用反事实进行推理或理解 "约翰太固执了,不能和他说话 "的句子--目前的模型实际上是正确的。乔姆斯基等人2023年的研究倾向于这些模型的想象版本,而忽略了真正的模型如此恰当地捕捉了句法这一事实,乔姆斯基和其他人一直声称这一成功是不可能的。

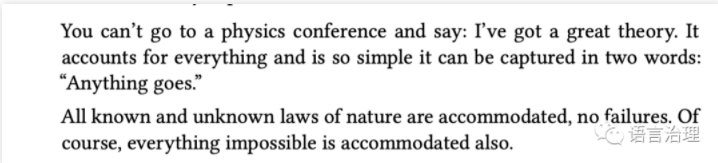

这种批评是对他(和其他人)关于语言学习的评论的一种熟悉的重新表述--基本上,我们不应该研究一个不受约束的系统,因为它不能解释为什么语言有它们的特定形式。但是,把现代语言模型否定为 "什么都可以",这种说法太粗糙了。原因是并非所有的 "任意 "模型都是等同的。众所周知,一个三层的神经网络能够接近任何可计算的函数(Siegelmann & Sontag 1995)。这也是一个 "无所不能 "的模型。但是三层网络在这种文本预测上不会有好的效果。事实上,即使是一些早期的神经网络模型,LSTM也没有做得那么好(Futrell etal.,2019,Marvin & Linzen 2018,Hu etal,2020);架构一般在捕捉字符串模式的计算类方面有所不同(例如Delétang etal.,2022)。原则上同样强大的模型表现不同,这就赋予了我们科学的杠杆作用。特别是,我们可以把每个模型或一组建模假设看作是关于心灵如何工作的可能假设。测试一个模型与人类行为的匹配程度,就可以对该模型的假设进行科学测试。例如,该领域就是这样发现注意力机制对表现良好很重要。同样,"消减 "实验允许研究人员改变网络的一个部分,并利用不同的性能来确定什么原则支持特定的行为(见Warstadt & Bowman 2022)。即使像所有的科学理论一样,我们发现它们在机制或表征方面如何与人不匹配,它们仍然是有信息的。听从乔治-博克斯的建议,"所有的模型都是错的,有些是有用的",我们可以思考这些模型的科学优势、贡献和弱点,而不需要完全接受或否定它们。事实上,这些模型已经做出了实质性的科学贡献,帮助划定了通过这种假设测试的可能性。是否有可能在没有内置等级制度的情况下发现它?词的预测能否提供足够的学习信号来获得大部分的语法?一个计算架构能否在没有运动的情况下实现对WH-问题的能力,或者在没有先天约束原则的情况下使用代词?最近的语言模型显示,所有这些问题的答案都是 "是"。

大型语言模型的成功是生成理论的失败,因为它几乎违背了这些理论所推崇的所有原则。事实上,乔姆斯基和那些在他的传统中工作的人长期以来声称必要的原则和先天偏见都不需要建立在这些模型中(例如绑定原则、二元分支、岛屿约束、空类别原则等)。此外,这些模型的建立没有纳入乔姆斯基的任何关键方法论主张,比如确保模型正确考虑能力与表现,尊重 "最小化 "或 "完美",并避免依赖未经分析的数据的统计模式。

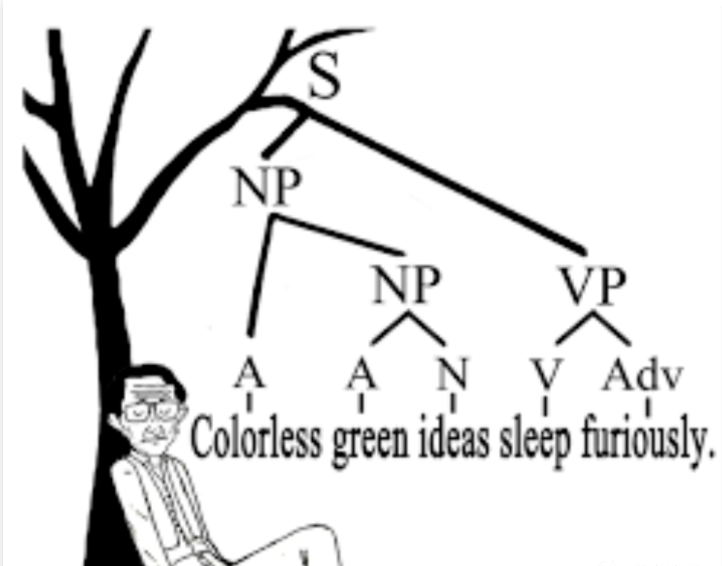

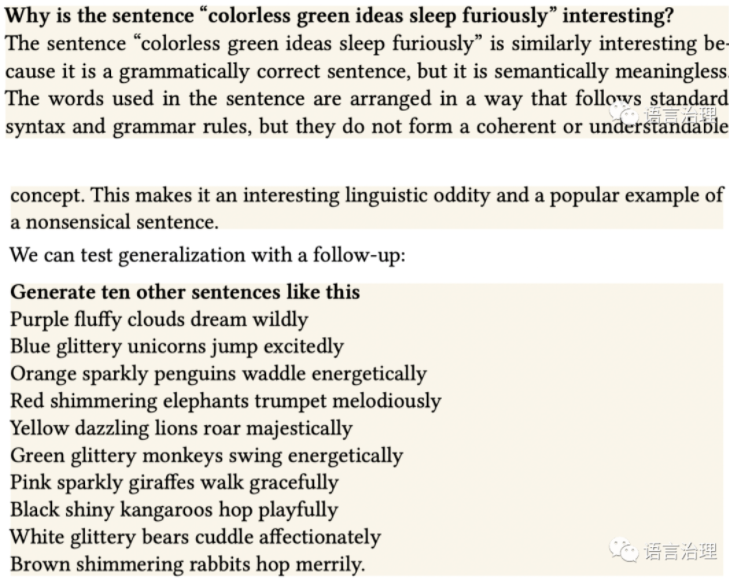

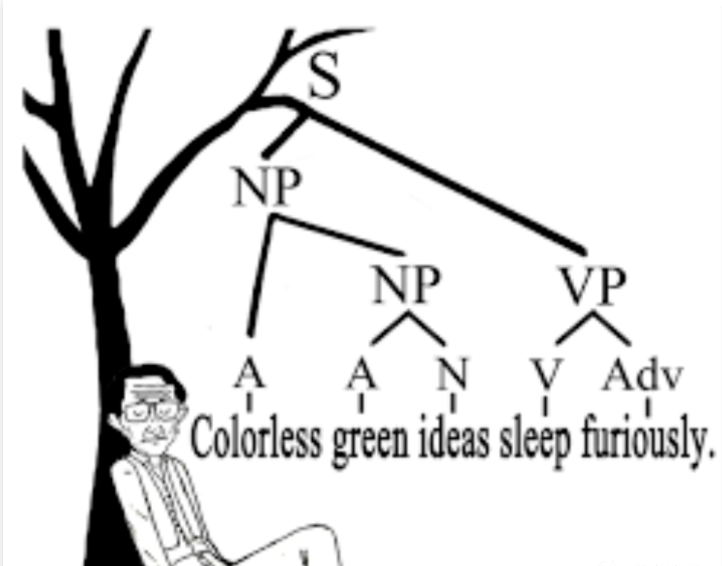

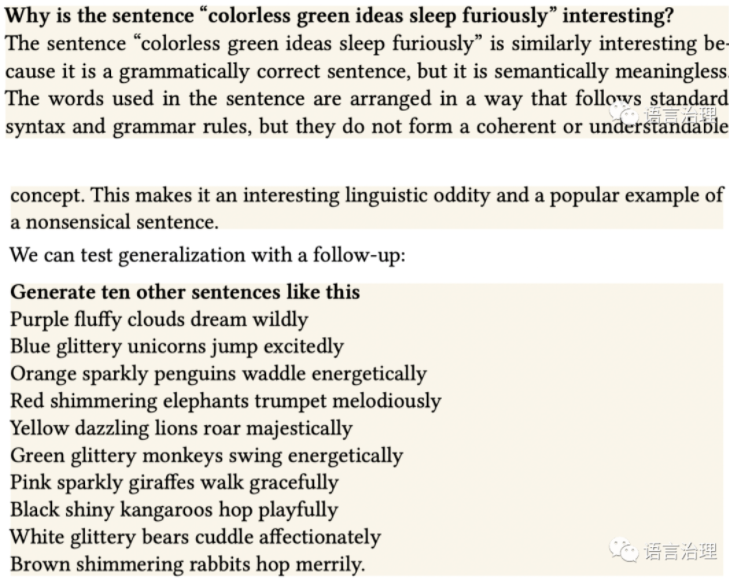

乔姆斯基和其他人长期以来一直强调将句法研究作为一个独立的实体,不仅与认知的其他部分,而且与语言的其他部分(例如,见乔姆斯基1957年,克罗夫特1995年,纽梅尔1991年,Adger 2018年)。这种方法中的句法不应该被还原为词与词之间的一般统计数字11--恰恰是大型语言模型现在提供的东西。现代大型语言模型在基础表征中整合了语法和语义:将单词编码为高维空间中的向量,而没有努力将例如语篇类别与语义表征分开,甚至没有在字面以外的任何分析层面进行预测。使这些模型运行良好的部分原因在于确定如何将语义属性编码到向量中,事实上,通过Mikolov等人2013年(Radford等人2019年)的分布语义的编码来初始化单词向量。因此,做预测句法材料的模型不需要假设句法的自主性,而且很可能妨碍它。我们可以用colorless green ideas sentence(见Gulordava etal.,2018)来试试,它通常被作为语法功能与语义分开的例子(而且过渡性概率统计是不够的),但这仍然是一个有趣的例子,部分原因是ChatGPT不仅可以学习相关的统计数据,而且可以创造--在这种情况下,肯定主要是反刍--对这句话为什么有趣的解释。

这个模型成功地得到了 "这个"(一个句子)的所指。该模型解决了 "像这样 "中的歧义,指的是句子的结构--这正是统计模型不应该知道的东西!它在句子中产生了一些但不完全是低频的大词。它在句子中生成了一些但不完全是低频的大词。我们可以注意到一个弱点,即它不太容易产生完全无意义的句子("黑色闪亮的袋鼠 "很罕见,但并非不可能),可能是因为无意义的语言在训练数据中很罕见。这些结果说明,即使是整合了句法和语义的模型也能够在适当的时候进行句法概括。语法在基础机制或模型的分析中不需要是自主的,以显示这种行为。第二点是,对于这些模型来说,概率和信息理论是核心。乔姆斯基长期以来一直对概率不屑一顾,他说 "必须认识到,在对这个术语的任何已知解释下,'一个句子的概率'的概念是一个完全无用的概念"(乔姆斯基1969),他几十年来一直坚持这一立场(诺维格2012)。12 通常,当那些在乔姆斯基传统下工作的人谈到概率模型时,他们指的是简单的东西,比如Shannon 1948的𝑛-gram模型,该模型计算了连续的单词共现,并长期用于自然语言处理任务(Chen & Goodman 1999, Manning & Schutze 1999)。但到现在,这样的模型已经过时了几十年。较新的模型使用概率来推断整个生成过程和结构,这是一个常见的认知任务和建模领域概率是模型的核心,因为概率预测本质上提供了一个错误信号,可以用来调整本身编码结构和生成过程的参数。一个比喻是,人们可以想象观察一个司机,并从观察中推断出相关的结构和动态--道路的规则(你在哪一边开车)、惯例(多辆车在停车标志前的行为)、软硬约束(不要转得太猛),等等。即使像这样一个简单的领域也面临着许多在语言中看到的不确定的问题,但它是一个很容易想象一个熟练的科学家或人类学家通过分析大量的数据发现关键因素的领域。在机器学习中也有类似的情况,可能的规则空间被隐含地编码为模型的参数(见上文)。值得注意的是,出于数字稳定性的考虑,大多数处理概率的模型实际上是用概率的对数工作的。以对数概率工作的模型实际上是在描述长度方面工作(Shannon 1948, Cover 1999):寻找使数据最可能的参数(最大化概率)与寻找给数据一个简短描述的参数(最小化描述长度或复杂性)是一样的。因此,最佳参数相当于科学理论,在描述长度的确切意义上,它能很好地压缩经验数据。概率远非 "完全无用",它是允许人们实际量化诸如复杂性和最小化的措施。预测是概率性的这一事实是有用的,因为它意味着基础表征是连续的和梯度的。与生成语言学典型的离散规则和过程的形式化工作不同(例如Chomsky 1956, 1995, Collins & Stabler 2016, Chomsky 1957, Pinker & Prince 1988),现代语言模型不使用(至少是明确的)规则和原则--它们基于一个连续的计算,允许多种影响因素对即将到来的语言项目产生梯度影响。这种方法的基础是由Rumelhart & McClelland 1986等早期建模者奠定的,他们在几十年前就论证了今天架构的关键特征,包括 "认知过程被看作是分级的、概率的、互动的、对环境敏感的和领域通用的"。(McClelland & Patterson 2002)。也许最值得注意的是,尽管现代语言模型的学习底层架构相对不受约束,但它们还是成功了。这是语言统计学习理论的一个明显胜利(见(Contreras Kallens等人,2023))。这些模型能够拟合大量可能的模式,虽然其架构的原则确实制约了它们,使一些模式比其他模式更容易,但所产生的系统是令人难以置信的灵活。尽管缺乏这种约束,该模型还是能够弄清语言的大部分运作方式。人们不应忽视 "刺激的贫困 "论点长期以来对生成语言学家所起的作用。接下来,在一个重要的意义上,大型语言模型不是最小的表征,而是最大的。我的意思是,没有一个核心的表征或结构的小块(如合并)导致这些模型的成功。任何反对派生复杂性的偏见也不可能发挥关键作用,因为一切都只是一个大的矩阵计算。而且,这种计算在结构上并不是极简主义语言学所指的最小或 "完美 "的(例如Lasnik 2002)。相反,大型语言模型的注意机制对任意遥远的材料进行调节,也许甚至没有结构上的关联,因为这就是它们在句子之间建立话语模型的方式。一个依赖于人们记忆无数语言块的能力的语法理论,改变了我们应该如何思考推导的格局;如上所述,基于概率的模型为语法中的复杂性概念提供了正式的立足点。深度学习实际上也改变了人们对统计学习中复杂性的看法。长期以来,人们观察到,在一个模型中拥有太多的参数会阻止该模型很好地泛化:太多的参数允许一个模型在噪声中适应模式,这可能导致它推断得很差。深度学习颠覆了这一观点,它表明一些模型会拟合(记忆)随机数据集(Zhang等人,2021年),这意味着它们可以拟合数据中的所有模式(包括噪声),并且泛化效果很好。记忆和泛化之间的关系仍然没有得到很好的理解,但其中一个核心含义是,统计学习模型有时可以很好地工作,即使是在过度参数化的情况下。有两个错误的做法很容易被发现。首先,即使一个模型有十亿个参数,它们一般也不会是独立的。这意味着一个数据点可以设置或移动数千或数百万或数十亿的参数。例如,观察一个带有SVO顺序的句子可能会增加(可能是数百万个)将S放在V之前的参数,并减少(可能是数百万个)将S放在V之后的参数。其次,这些模型或学习者往往不需要精确地确定一个答案。一个叫做彩票假说的猜想认为,深度学习模型的行为往往是由其相对较少的神经元决定的(Frankle & Carbin 2018)。因此,大量的参数并不是因为它们都需要被精确地设置为某个值。相反,拥有许多自由度可能有助于这些模型的良好学习,因为它给了模型可以移动的方向,以避免陷入困境。这可能就像如果你能把棋子拿起来放下去(在第三维度上移动它们),而不是仅仅在桌子上滑动它们,就会更容易解决一个拼图。更多的自由度可以帮助学习。最后,这些模型从他们的训练中发现了结构--包括层次结构。这些模型当然可以学习基于线性结构而不是层次结构的规则,但数据强烈地引导它们走向层次结构的泛化。这种发现层次结构而不是建立层次结构的能力是认知心理学家长期强调的,例如通过聚类诱导句法类别的工作,他们表明应用于儿童定向语音的贝叶斯模型比较可以识别出一个无语境(层次)的语法,而不是替代品。最近的模型建立在早期将分层过程编码到神经网络的努力之上。我们熟悉的aux-inversion的例子是为了说明儿童必须拥有层次化的语法。作为一个简单的实验,我们也可以要求这些模型来形成一些问题。例如,我们熟悉的aux-inversion。在乔姆斯基看来,人类的语言与人类的思想有着深刻的内在联系。乔姆斯基2002年将语言描述为 "一个表达思想的系统",事实上,这个系统主要用于自言自语。有趣的是,他没有借鉴关于内心独白的文献,这些文献显示了个体之间的巨大差异,有些人几乎完全没有描述内部语言的使用(例如Reed 1916,Heavey & Hurlburt 2008,Roebuck & Lupyan 2020)。不过,乔姆斯基的观点也许因以下论点而更加可信:思想本身具有许多语言的属性,即一种类似于语言的组成结构(Fodor 1975, Fodor & Pylyshyn 1988, Goodman et al. 2014, Piantadosi & Jacobs 2016, Quilty-Dunn et al. 2022)。乔姆斯基经常将他的语言内在思维观点与语言主要是为支持交流而结构化的观点进行对比(如Hockett 1959, Bates & MacWhinney 1982, Gibson et al. 2019),尽管值得注意的是他有时会得出与高效交流实际预测相反的预测(如Piantadosi et al.) Mahowald和Ivanova等人2023年在一篇综合评论中认为,大型语言模型在语言能力和思维之间表现出引人注目的分离。这些模型知道这么多的语法和语义的各个方面,但是用适当的逻辑推理任务来绊倒它们并不难。因此,大型语言模型提供了一个原则性的证明,即语法可以存在,并可能与其他更强大的思维和推理形式分开获得。我们在语言中看到的几乎所有结构都可以来自于学习一个好的字符串模型,而不是直接对世界进行建模。

乔姆斯基经常将自己的方法描述为 "伽利略式",意思是说他在现象中寻找基本原理,而不是分析大量数据。这个词既是一个误称(Behme 2014),也是对选择从不同假设出发的同事的一种不那么隐晦的侮辱。当然,伽利略关心对世界的定量测量,以制定理论,发展自己的工具,甚至试图测量光速。乔姆斯基的观点在2012年对亚登-卡茨的采访中得到了清晰的阐述,当时,他专注于解释贝叶斯模型是无用的。

我试图传达我自己对大型语言模型的兴奋感,以及我自己对乔姆斯基的语言学方法的几个方面的悲观情绪。然而,不难看出,除了上述的批评之外,乔姆斯基的许多强调的重点将在他的具体理论中得以延续。例如,乔姆斯基对认知科学的持久贡献之一将是他对认知结构现实的强调,就像托尔曼、纽维尔和西蒙、米勒以及认知革命中的其他人一样(Nadel & Piattelli-Palmarini 2003, Boden 2008)。寻找允许成功获得语言的人类认知属性,显然不仅是理解心智运作的核心,也是理解人类的核心。试图描述语言所需的计算,并将其视为真正的心智计算,这是一个深刻而重要的想法。乔姆斯基对儿童作为语言创造者的关注,以及对他们的偏见如何影响学习的理解,是任何认知的科学理论的基础。秉承乔姆斯基传统的语言学工作为记录和支持不太广泛使用的语言做了大量的工作,这是目前机器学习的奋斗目标(Blasi等人,2021)。对 "为什么 "问题的整体探索无疑是该领域的核心,即使我们拒绝或完善了扶手椅假说。乔姆斯基方法的一些想法甚至可能在语言模型中找到。例如,许多语言是分层的这一观点很可能是正确的,它以某种方式体现在在单词预测方面表现良好的神经网络的连接和链接中。可能在某种意义上,语言学所考虑的其他原则也以某种形式存在于此类模型中。如果这些模型在绑定问题上表现正确,它们可能有一些类似于绑定原则的计算。但这些原则都不需要是天生的。而在神经网络中,它们是以迄今为止没有人写过的形式实现的--它们是通过连续的、梯度的连接的大模式分布的。此外,像捆绑这样的东西的表征极不可能具有生成语法所预测的形式,因为该方法所要求的、基本的表征假设(如二进制分支、特定的派生结构等)没有得到满足。乔姆斯基的研究项目的另一个关键贡献是鼓励发现有趣的句子类别,通常是通过像Ross 1967这样的人。例如,不管该领域对WH-运动的真实性有什么不同看法,什么决定了WH-句子的语法性和非语法性,这是一个重要问题。同样,像 "岛屿 "这样的现象也不会因为大型语言模型而消失--它们是要被解释的目标(根据Wilcox等人2022年的分析,它们做得相当好)。这样的现象往往很难与理论分开,就像上面关于陈述句和问句在真实语法中是否真的有联系的例子。无论理论如何,按照乔姆斯基的传统工作的研究人员已经照亮了许多地方,在这些地方,人类的语言行为比人们预期的更加复杂或错综复杂。正如Pater 2019年所阐述的,该领域应寻求将语言学与现代机器学习(包括神经网络)相结合的方法。我已经强调了一些研究人员,他们对语言的研究方法显然与现代语言模型的见解有共鸣。目前的动荡表明,我们应该培养一种多元化的语言学,以尽可能少的先入为主来处理语言问题--也许甚至可以从根本上重新认识语言的作用和它的样子(Edelman 2019)。也许乔姆斯基理论所关注的许多 "句法 "现象实际上是关于其他东西的,比如语用学或记忆结构(Goldberg 2006, Liu et al. 2022)。也许语言的普遍性--如果有的话--来自使用的各个方面,比如交际和认知压力,或者其他文化因素。也许语言学可以向认知科学的方法学习(Edelman 2007)。也许语法理论应该尊重人类对序列材料无与伦比的记忆能力。也许我们应该让语言学学生学习信息论、概率论、神经网络、机器学习、人类学、数字方法、模型比较、科尔莫戈罗夫复杂性、认知心理学、语言处理、多代理系统等等。乔姆斯基的方法的最永久的遗产可以作为对语言研究与科学的其他部分分离时发生的情况的告诫。我们必须坦诚地对待捕捉句法的模型的技术现状。这并不是说大型语言模型比语言学中的其他方法性能略高;也不是说它们能更好地覆盖句法的某些角落。而是在所有的语言学理论中,没有任何东西能与大型语言模型在句法和语义方面的力量相提并论,更不用说话语连贯性、风格、语用学、翻译、元语言意识、非语言任务等等。它们在所有方面都是游戏规则的改变者。那些认为它们至少是一个合理的习得方向的乐观主义者认为它们是建立和测试架构原则和偏见的一种方式,这些原则和偏见是连接主义模型师(如McClelland etai.1986、Elman etal.1996年、Smolensky & Legendre etal. 2006 )长期强调的。那些怀疑它们能否作为习得模型发挥作用的人,还是应该看到梯度表征、架构假设和隐含或涌现原则作为语法理论的成功。这些模型打开了可信的语言学理论的空间,使我们能够测试传统上关注语言学家的原则之外的原则。它们使我们最终能够发展出令人信服的结构和统计学相互作用的理论。而且,它们似乎解决了生成式句法学家所担心的许多问题,但没有使用他们的任何理论工具和构造。大型语言模型改写了语言研究方法的哲学。本文选节选译自Modern language models refute Chomsky’s approach to language,欢迎扫码获取原文一起烧脑