985 阅读 2020-08-19 09:18:02 上传

以下文章来源于 语言学考研

首先来看计算机视觉论文:

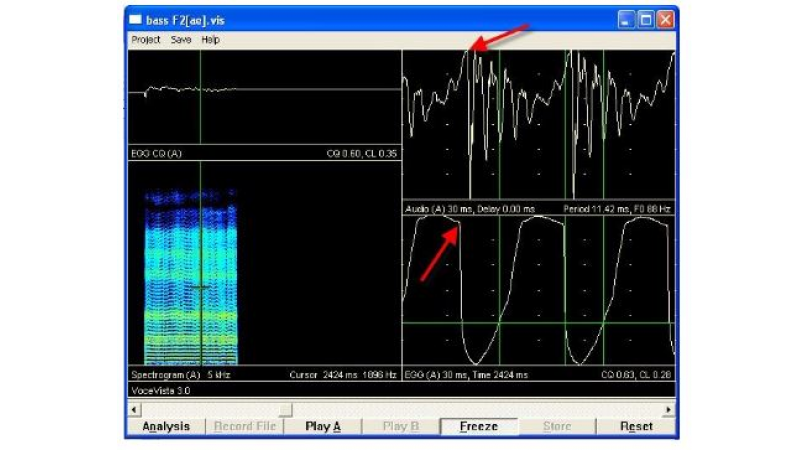

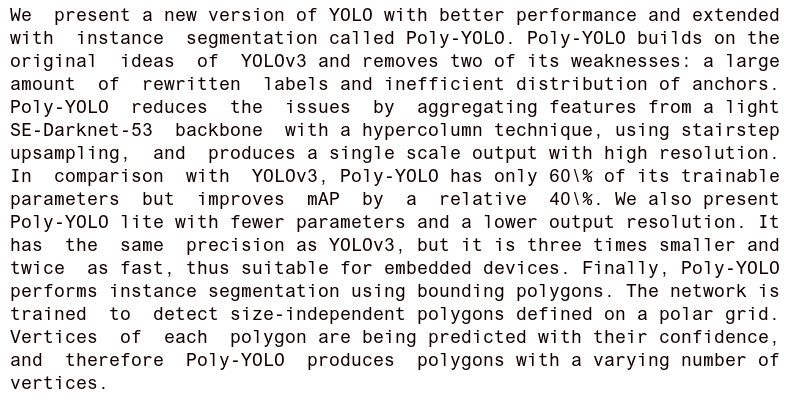

- [1]提出了一个新的YOLO,它具有更好的性能,并扩展了实例分割,称为Poly-YOLO。Poly-YOLO以YOLOv3的原始思想为基础,消除了它的两个缺点:大量重写的标签和低效的锚分布。Poly-YOLO使用超柱(Hypercolumn)技术将轻量级SE-Darknet-53主干的特征进行聚合,使用阶梯向上采样,从而减少问题的出现,并生成具有高分辨率的单尺寸输出。与YOLOv3相比,Poly-YOLO只有60%的可训练参数,但是相对提高了40%的mAP。文章还提供了参数更少、输出分辨率更低的Poly-YOLO lite。它具有与YOLOv3相同的精度,但比YOLOv3小三倍,快两倍,因此适合于嵌入式设备。最后,Poly-YOLO使用包围多边形来执行实例分割。该网络在经过训练后,可以检测在极性网格上定义的与大小无关的多边形。每个多边形的顶点都有各自的置信度,因此Poly-YOLO生成具有不同数量顶点的多边形。

自然语言处理方面:

- 最近的研究工作通过对大量文本进行预训练,然后对特定任务进行微调,在许多自然语言处理任务和基准方面取得巨大收获。这类策略尽管在结构上通常是与任务无关的(task-agnostic),但是仍需包含成千上万个样例的、该任务独有的数据集用于微调。相比之下,人类通常只通过几个示例或简单指令就可以执行新的语言任务——当前的NLP系统很大程度上仍难以做到这点。[9]表明,扩大语言模型可以极大提高其在任务无关、少次学习情况下的性能,有时这种调整甚至可以使模型与现有最佳方法取得相当的优异结果。具体而言,研究者训练了GPT-3(一种具有1750亿个参数的自回归语言模型,比以前的任何非稀疏语言模型大10倍),并在少次学习设置(few-shot setting)中测试其性能。对所有任务,应用GPT-3无需进行任何梯度更新或微调,而仅通过与模型的文本交互指定任务和少次演示即可。GPT-3在许多NLP数据集上均具出色性能,包括翻译、问答和完形填空、以及一些需要即时推理或领域自适应的任务,例如单词解译(unscrambling words),在句中使用新词(using a novel word in a sentence),或进行3位数字运算(performing 3-digit arithmetic)。同时,研究者还明确了一些数据集,在其中即使如GPT-3去进行少次学习仍感到困难。另外还存在一些数据集,用于考察GPT-3在大型Web语料库上进行训练的相关方法论问题(methodological issues)。最后,研究者发现GPT-3可以生成新闻文章的样本,人类评估人员很难将这种生成样本与人类撰写的文章区分开。研究者将讨论这一发现以及GPT-3的广泛社会影响。

- 在开放域对话系统中,确定每个用户话语的主题(域)是所有后续语言理解和响应任务的关键步骤。特别是对于复杂的域,话语通常会寻路到负责该域的单个组件。因此,正确将用户话语映射到正确域至关重要。为解决此问题,[10]介绍ConCET:并发实体感知会话主题分类器,其将实体类型信息与话语内容功能结合在一起。具体而言,ConCET利用实体信息来丰富发声表示,将字符、单词和实体类型的嵌入组合为单个表示。但是,对于具有数百万个可用实体的丰富域,将需要海量的带标签训练数据。为补充所提模型,研究者又提出一种简单有效的方法来生成综合训练数据,以使用通常可用的知识库生成其他标记话语来增加通常有限数量的标记训练数据。首先,研究者在一个公开的人与人对话数据集Self-Dialogue上广泛评估ConCET和所提训练方法,以将所提方法与当前最佳方法进行校准;其次,研究者在与真实用户的大型人机对话数据集上评估了ConCET,该数据集是Amazon Alexa Prize的一部分。实验结果表明,ConCET在这两个数据集上,与最新深度学习方法相比,显著提高了主题分类性能约8-10%。研究者通过对系统性能的详细分析来补充定量结果,该分析可用于进一步改进会话代理。

- 问答(QA)中最关键的挑战之一是标记数据的稀缺性,因为获取带有人工标注的目标文本域的QA对非常昂贵。解决问题的一种方法是使用从问题上下文或大量非结构化文本(如Wikipedia)中自动生成的QA对。[7]提出一种分层条件变分自编码器(Hierarchical Conditional Variational Autoencoder,HCVAE),用于在给定非结构化文本作为上下文的情况下生成QA对,同时最大化生成QA对之间的互信息以确保它们的一致性。通过仅使用生成的QA对(基于QA评估)或通过使用生成的和人为标记的对(半监督学习)评估QA模型(基于BERT的性能),研究者在几个基准数据集上验证了所提的信息最大化层级变分自编码器(Info-HCVAE)。结果表明,即使仅使用部分数据训练,该模型仍在两项任务的所有基线上均获得令人印象深刻的性能提升。

- 变分神经机器翻译(Variational Neural Machine Translation,VNMT)是一个有吸引力的框架,可用于对目标翻译的生成进行建模,结果不仅取决于源语句,且取决于某些潜在的随机变量。潜在变量建模可能会引入有用的统计依存关系,从而提高翻译准确性。但是学习带有信息的潜在变量并不简单,因为潜在空间可能过大,且在训练时许多翻译模型都容易忽略潜在编码(latent codes)。现有研究对潜在代码的分布强加了假设,并限制了NMT架构的选择。[11]提议将VNMT框架应用于当前最佳Transformer,并基于归一化流引入一个更灵活的近似后验。研究者证明所提方法在域内和域外条件下都具有有效性,且明显优于强基准。

- 语音识别(ASR)和机器翻译(MT)的端到端模型,相比于传统的单独的ASR和MT的级联模型,结合的更加紧密,具有更简单的模型体系结构和减少错误传播的潜力。他们的表现往往被认为是优越的,虽然在许多情况下还不是这样。[8]比较了高、中、低资源条件下的级联和端到端模型,并表明级联模型仍然是更强的基线。此外,文章还介绍了两种将手机特征纳入ST模型的方法。文章展示了这些特性改进了这两个架构,缩小了端到端模型和级联模型之间的差距,并且比以前的学术工作表现更好。

除此之外,本期还有如下看点:

- IMDb.com是依靠用户规范维持的电影评分门户网站,也是访问量最大的门户之一,这为创建巨大的数据库提供了机会。分析与电影有关或由用户提供的互联网电影数据库IMDb上的信息,将有助于揭示每部电影成功途径的决定性因素。基于此,[21]使用统计方法和机器学习模型为以后的分析创建了一个大规模数据集,这是针对前述目标的一系列论文中的第一篇,其中简要介绍了创建的数据集和数据分析演示。

- INTERSPEECH 2020深度噪声抑制(Deep Noise Suppression,DNS)挑战赛旨在促进实时单通道语音增强中的协作研究,目标是最大程度增强语音的主观(感知)质量。评估噪声抑制方法的一种典型策略是在通过划分原始数据集而获得的测试集上使用客观指标。尽管综合测试集的性能很好,但实际记录的模型性能通常会大幅降低。此外,大多数常规客观指标与主观测试之间的关联度不高,且实验室主观测试无法针对大型测试集进行扩展。在该竞赛中,[23]开源了一个大型干净语音和噪声语料库,用于训练噪声抑制模型和具有代表性的测试集,以适应由合成和真实录音组成的真实场景。研究者还开放了基于ITU-T P.808的在线主观测试框架,供研究人员可靠测试其研发框架。研究者在盲测装置上使用P.808评估结果,并讨论了挑战的结果和主要经验教训。

- 近年来,少次学习(Few-Shot learning,FSL)吸引了越来越多的关注,但由于的确很难从几个样例里进行概括,因而该任务仍具有挑战。[25]提出一种自适应边际原理(adaptive margin principle),以提高基于度量的元学习方法对少次学习问题的泛化能力。具体而言,首先研发与类相关的加法边际损失,其中考虑每对类之间的语义相似性以将特征嵌入空间中的样本与相似类分开。其次,将语义上下文纳入样本训练任务中的所有类别间,并开发与任务相关的额外边际损失(additive margin loss),以更好区分不同类的样本。所提方法可以轻松扩展到更现实的广义FSL场景中。大量实验表明,该方法在标准FSL和广义FSL设置下均可提高当前基于度量的元学习方法的性能。

- 统计信号处理和机器学习中最重要的挑战之一是如何获得一个生成模型,它可以生成大规模数据分布的样本,例如图像和语音。生成对抗网络(GAN)是解决这一问题的有效方法。GANs提供了一种适当的方法来学习深层表示,而不需要使用大量的标记训练数据。该方法无需对概率密度函数(PDF)进行精确建模就能生成大量数据,引起了计算机视觉领域众多研究者的关注。在GANs中,生成模型是通过同时训练生成器和鉴别器网络的竞争过程来估计的。生成器学习生成可信的数据,鉴别器学习将生成器生成的虚假数据与真实数据样本区分开来。鉴于近年来GANs的快速发展及其在各个领域的应用,有必要对这些网络进行准确的研究。[29]在介绍GAN的主要概念和理论的基础上,对两种新的深层生成模型进行了比较,并对文献中使用的评价指标和GANs面临的挑战进行了说明。

- [30]调查了146篇分析自然语言处理(NLP)系统中关于“偏移”(bias)的论文,发现尽管分析“偏移”是一个固有的规范过程,但其动机常常是模糊、不一致和缺乏规范性推理的。研究者进一步发现,这些论文提出的用于测量或缓解“偏移”的定量技术与其动机很不匹配,且与NLP之外的相关文献不符。基于这些发现,研究者力图通过提出三个建议来指导NLP系统相关工作未来对“偏移”的分析方法。这些提议基于对语言和社会层级之间关系的更多认识,鼓励研究人员和从业人员阐明其对“偏移”的概念化,即,哪种系统行为有害、以何种方式、对谁、为什么,以及这些陈述所依据的规范性推理。同时围绕受NLP系统影响的社区成员的生活经验进行集中研究,并审视和重新构想技术人员与此类社区之间的权力关系。

- “非平稳性”是协作多智能体强化学习(MARL)中一个基本的棘手问题:由于其他智能体在学习,每个智能体必须重新学习关于其他智能体策略的信息,导致信息在智能体之间形成了“环”,因此收敛速度变慢。MAILP模型(Terry et al., 2020)是一种新的多agent学习过程中的信息传递模型。[33]使用MAILP模型来表明,增加训练的集中化可以缓解由于非平稳性而导致的收敛速度减慢。最集中化的学习策略是参数共享,这是一种不常用的MARL方法,专门用于具有同构代理的环境。文章在Gupta等人(2017)的MARL基准集上实验复制了增加学习集中化导致更好性能的结果。文章在文献中首次将参数共享进一步应用于8种“更现代”的单代理深度强化学习方法。基于此,文章在一组MARL基准上获得了最好的记录性能,并且与现有的参数共享方法相比,文章提出的方法在少至7%的时间内获得了高达720%的平均回报。

最后,本期还包含2个新构造的数据集[21-22],2个新提出的任务[23-24],3篇综述[29-31],以及其他技术。

计算机视觉

Computer Vision

[1]

Poly-YOLO: higher speed, more precise detection and instance segmentation for YOLOv3

Petr Hurtik, Vojtech Molek, Jan Hula, Marek Vajgl, Pavel Vlasanek, Tomas Nejezchleba

摘 要:

原 文:http://arxiv.org/pdf/2005.13243v1

[2]

P2B: Point-to-Box Network for 3D Object Tracking in Point Clouds

Haozhe Qi, Chen Feng, Zhiguo Cao, Feng Zhao, Yang Xiao

摘 要:

原 文:http://arxiv.org/pdf/2005.13888v1

资 源:github.com/HaozheQi/P2B

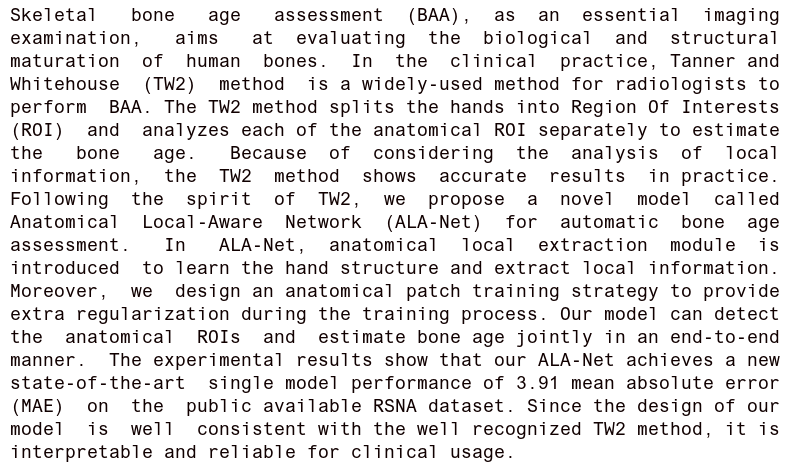

[3]

Improve bone age assessment by learning from anatomical local regions

Dong Wang, Kexin Zhang, Jia Ding, Liwei Wang

摘 要:

原 文:http://arxiv.org/pdf/2005.13452v1

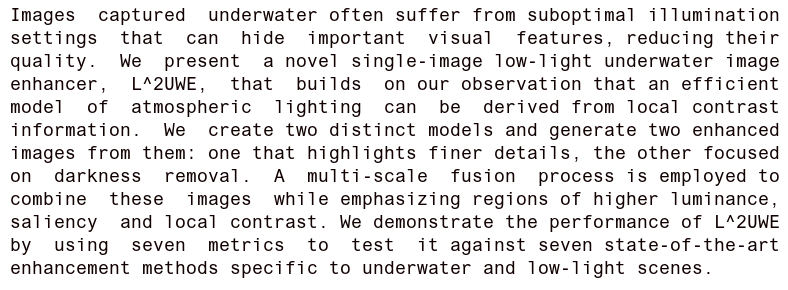

[4]

L^2UWE: A Framework for the Efficient Enhancement of Low-Light Underwater Images Using Local Contrast and Multi-Scale Fusion

Tunai Porto Marques, Alexandra Branzan Albu

摘 要:

原 文:http://arxiv.org/pdf/2005.13736v1

[5]

Deep Learning for Automatic Pneumonia Detection

Tatiana Gabruseva, Dmytro Poplavskiy, Alexandr A. Kalinin

摘 要:

原 文:http://arxiv.org/pdf/2005.13899v1

资 源:github.com/tatigabru/kaggle-rsna, github.com/yhenon/pytorch-retinanet

[6]

Network Fusion for Content Creation with Conditional INNs

Robin Rombach, Patrick Esser, Björn Ommer

摘 要:

原 文:http://arxiv.org/pdf/2005.13580v1

自然语言处理

Natural Language Processing

[7]

Generating Diverse and Consistent QA pairs from Contexts with Information-Maximizing Hierarchical Conditional VAEs

Dong Bok Lee, Seanie Lee, Woo Tae Jeong, Donghwan Kim, Sung Ju Hwang

摘 要:

原 文:http://arxiv.org/pdf/2005.13837v1

资 源:github.com/seanie12/Info-HCVAE

[8]

Phone Features Improve Speech Translation

Elizabeth Salesky, Alan W Black

摘 要:

原 文:http://arxiv.org/pdf/2005.13681v1

[9]

Language Models are Few-Shot Learners

Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei

摘 要:

原 文:http://arxiv.org/pdf/2005.14165v1

资 源:github.com/openai/gpt-3

[10]

ConCET: Entity-Aware Topic Classification for Open-Domain Conversational Agents

Ali Ahmadvand, Harshita Sahijwani, Jason Ingyu Choi, Eugene Agichtein

摘 要:

原 文:http://arxiv.org/pdf/2005.13798v1

资 源:github.com/jfainberg/

self_dialogue_corpus,

github.com/emory-irlab/ConCET,

github.com/zonetrooper32/VDCNN

[11]

Variational Neural Machine Translation with Normalizing Flows

Hendra Setiawan, Matthias Sperber, Udhay Nallasamy, Matthias Paulik

摘 要:

原 文:http://arxiv.org/pdf/2005.13978v1

[12]

HAT: Hardware-Aware Transformers for Efficient Natural Language Processing

Hanrui Wang, Zhanghao Wu, Zhijian Liu, Han Cai, Ligeng Zhu, Chuang Gan, Song Han

摘 要:

原 文:http://arxiv.org/pdf/2005.14187v1

资 源:github.com/moses-smt/mosesdecoder

[13]

Neural Temporal Opinion Modelling for Opinion Prediction on Twitter

Lixing Zhu, Yulan He, Deyu Zhou

摘 要:

原 文:http://arxiv.org/pdf/2005.13486v1

[14]

Contextual Dialogue Act Classification for Open-Domain Conversational Agents

Ali Ahmadvand, Jason Ingyu Choi, Eugene Agichtein

摘 要:

原 文:http://arxiv.org/pdf/2005.13804v1

资 源:github.com/emory-irlab/CDAC, github.com/cgpotts/swda

[15]

User Intent Inference for Web Search and Conversational Agents

Ali Ahmadvand

摘 要:

原 文:http://arxiv.org/pdf/2005.13808v1

[16]

Joint Modelling of Emotion and Abusive Language Detection

Santhosh Rajamanickam, Pushkar Mishra, Helen Yannakoudakis, Ekaterina Shutova

摘 要:

原 文:http://arxiv.org/pdf/2005.14028v1

[17]

Attention in Natural Language Processing

Andrea Galassi, Marco Lippi, Paolo Torroni

摘 要:

原 文:http://arxiv.org/pdf/1902.02181v2

[18]

Language Representation Models for Fine-Grained Sentiment Classification

Brian Cheang, Bailey Wei, David Kogan, Howey Qiu, Masud Ahmed

摘 要:

原 文:http://arxiv.org/pdf/2005.13619v1

[19]

Would you Like to Talk about Sports Now? Towards Contextual Topic Suggestion for Open-Domain Conversational Agents

Ali Ahmadvand, Harshita Sahijwani, Eugene Agichtein

摘 要:

原 文:http://arxiv.org/pdf/2005.13803v1

[20]

Good Counterfactuals and Where to Find Them: A Case-Based Technique for Generating Counterfactuals for Explainable AI (XAI)

Mark T. Keane, Barry Smyth

摘 要:

原 文:http://arxiv.org/pdf/2005.13997v1

数据集

Dataset

[21]

IMDb data from two generations (1979 to 2019). Part one: Dataset

M. Bahraminasr, A. Vafaei Sadr

摘 要:

原 文:http://arxiv.org/pdf/2005.14147v1

[22]

A Corpus for Large-Scale Phonetic Typology

Elizabeth Salesky, Eleanor Chodroff, Tiago Pimentel, Matthew Wiesner, Ryan Cotterell, Alan W Black, Jason Eisner

摘 要:

原 文:http://arxiv.org/pdf/2005.13962v1

任务与挑战

Task & Challenge

[23]

The INTERSPEECH 2020 Deep Noise Suppression Challenge: Datasets, Subjective Testing Framework, and Challenge Results

Chandan K. A. Reddy, Vishak Gopal, Ross Cutler, Ebrahim Beyrami, Roger Cheng, Harishchandra Dubey, Sergiy Matusevych, Robert Aichner, Ashkan Aazami, Sebastian Braun, Puneet Rana, Sriram Srinivasan, Johannes Gehrke

摘 要:

原 文:http://arxiv.org/pdf/2005.13981v1

资 源:github.com/microsoft/P.808, github.com/microsoft/MS-SNSD, github.com/microsoft/DNS-Challenge, github.com/microsoft/onnxruntime

[24]

The SIGMORPHON 2020 Shared Task on Unsupervised Morphological Paradigm Completion

Katharina Kann, Arya McCarthy, Garrett Nicolai, Mans Hulden

摘 要:

原 文:http://arxiv.org/pdf/2005.13756v1

资 源:github.com/sigmorphon/2020

方法论

Methodology

[25]

Boosting Few-Shot Learning With Adaptive Margin Loss

Aoxue Li, Weiran Huang, Xu Lan, Jiashi Feng, Zhenguo Li, Liwei Wang

摘 要:

原 文:http://arxiv.org/pdf/2005.13826v1

[26]

ODEN: A Framework to Solve Ordinary Differential Equations using Artificial Neural Networks

Liam L. H. Lau, Denis Werth

摘 要:

原 文:http://arxiv.org/pdf/2005.14090v1

资 源:github.com/deniswerth/ODEN

[27]

Few-Shot Open-Set Recognition using Meta-Learning

Bo Liu, Hao Kang, Haoxiang Li, Gang Hua, Nuno Vasconcelos

摘 要:

原 文:http://arxiv.org/pdf/2005.13713v1

神经网络原理

Neural Network Theory

[28]

QEBA: Query-Efficient Boundary-Based Blackbox Attack

Huichen Li, Xiaojun Xu, Xiaolu Zhang, Shuang Yang, Bo Li

摘 要:

原 文:http://arxiv.org/pdf/2005.14137v1

资 源:github.com/AI-secure/QEBA

综述

Survey

[29]

Generative Adversarial Networks (GANs): An Overview of Theoretical Model, Evaluation Metrics, and Recent Developments

Pegah Salehi, Abdolah Chalechale, Maryam Taghizadeh

摘 要:

原 文:http://arxiv.org/pdf/2005.13178v1

[30]

Language (Technology) is Power: A Critical Survey of "Bias" in NLP

Su Lin Blodgett, Solon Barocas, Hal Daumé III, Hanna Wallach

摘 要:

原 文:http://arxiv.org/pdf/2005.14050v1

[31]

Adversarial Attacks and Defense on Textual Data: A Review

Aminul Huq, Mst. Tasnim Pervin

摘 要:

原 文:http://arxiv.org/pdf/2005.14108v1

语音技术

Audio & Speech

[32]

Subword RNNLM Approximations for Out-Of-Vocabulary Keyword Search

Mittul Singh, Sami Virpioja, Peter Smit, Mikko Kurimo

摘 要:

原 文:http://arxiv.org/pdf/2005.13827v1

强化学习

Reinforcement Learning

[33]

Parameter Sharing is Surprisingly Useful for Multi-Agent Deep Reinforcement Learning

Justin K Terry, Nathaniel Grammel, Ananth Hari, Luis Santos, Benjamin Black, Dinesh Manocha

摘 要:

原 文:http://arxiv.org/pdf/2005.13625v1

资 源:github.com/openai/baselines

[34]

ALBA : Reinforcement Learning for Video Object Segmentation

Shreyank N Gowda, Panagiotis Eustratiadis, Timothy Hospedales, Laura Sevilla-Lara

摘 要:

原 文:http://arxiv.org/pdf/2005.13039v1

[35]

Deep Reinforcement learning for real autonomous mobile robot navigation in indoor environments

Hartmut Surmann, Christian Jestel, Robin Marchel, Franziska Musberg, Houssem Elhadj, Mahbube Ardani

摘 要:

原 文:http://arxiv.org/pdf/2005.13857v1

推荐系统

Recommendation System

[36]

User Behavior Retrieval for Click-Through Rate Prediction

Jiarui Qin, Weinan Zhang, Xin Wu, Jiarui Jin, Yuchen Fang, Yong Yu

摘 要:

原 文:http://arxiv.org/pdf/2005.14171v1

资 源:github.com/qinjr/UBR4CTR

[37]

Operationalizing the Legal Principle of Data Minimization for Personalization

Asia J. Biega, Peter Potash, Hal Daumé III, Fernando Diaz, Michèle Finck

摘 要:

原 文:http://arxiv.org/pdf/2005.13718v1

医疗与健康

Medical Science & Health Care

[38]

CNN-based Approach for Cervical Cancer Classification in Whole-Slide Histopathology Images

Ferdaous Idlahcen, Mohammed Majid Himmi, Abdelhak Mahmoudi

摘 要:

原 文:http://arxiv.org/pdf/2005.13924v1

应用

Application

[39]

Code Duplication and Reuse in Jupyter Notebooks

Andreas Koenzen, Neil Ernst, Margaret-Anne Storey

摘 要: